中小企業様の社員研修事業を行なっておりますが

その中で企業様の様々なデータを事前にお渡し頂き

講師の方でデータ分析を行わせて頂き、その分析データを活用しながら

研修のテーマ(改善モデルのテーマ)とさせて頂いております。

その中で感じる事ですが

特にISO取得会社などは多くの「データ」を取得しております。

ISO監査や自社内の自主ルールを定め

「データ取得」を推進していると思われます。

これはこれで素晴らしい事であり、データは分析する事で戦略情報になります。

しかし、ながら研修先企業の多くは「データ取得」が仕事になっており

「データ活用」までに進んでいない

このような状況を目にします。

品質担当の方は「データは有ります」とおっしゃいます

「データは活用してますか?」「…」

この様な形です。

この件はかなり重要な事で、データを取得するゴールまで見据えておらず

先ずは「とりあえずデータを取得しなさい」が先に来ます

これはこれで仕方ない事でも有り

先ずはデータ無くしては、その次に進まないですからね。

今までは勘と経験、度胸(KKD)で進めて来た時代に

ISO(国際標準)の考え方が浸透し、データに基づくアクション

と言うモノが進んだ所でも有ります。

データを取得する事は進みました

次はこの「データを活かす事」ここが研修の肝になります。

そこで冒頭のデータ分析になります。

データ分析に関しては様々なテクニックがあり

この分野は研究開発が進んでおりますが

難しい研究分析テクニックは一旦置いておいて

先ずは「層別分析」のテクニックを事例を交えて

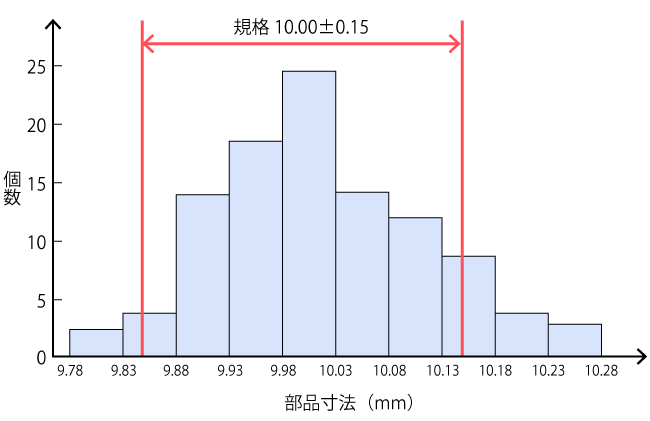

一般的にはモノつくり会社での「データ」と言いますと

モノを作る段階での「品質データ:検査データ、測定データ、時間、担当、装置 etc」

モノを作った段階の「不良項目、不良個数、損失金額、発生工程、装置状態 etc」

この様なデータが有ると思います。

ここで一旦「ビッグデータ」に話題を移します。

皆さんは「ビッグデータ」と言うと、どの様なイメージを持ちますか?

「Googleやアマゾンの様な何千何万と言う大量データ」

と言うイメージを持ちそうです。

なので「ビッグデータ」と中小企業ではあまり結びつかない

と思い込んでいらっしゃるケースが多いです。

しかし、何千何万とは言わず数百件レベルでも

充分に分析出来、傾向をつかむことが可能になります。

それが層別分析になります。

先ずは数百件データ(数ヶ月分)をExcel等を活用し

項目毎に集結してみて下さい。

例とすると

・不良内容の発生件数(%)

・装置別不良発生件数(%)

・作業者別の不良発生件数(%)

・日付、時間別の不良発生件数(%)

データ項目が多い程深みが出て深度が高まります。

多くの場合、ここまでである程度の

傾向を捉える事が可能です。

ここまでは難しい技術無くても、Excelが使えれば

ある程度の分析が進み、大きな傾向までは把握が出来ます。

ここまで来れば、データ取得が「目的から手段」に昇華します。

一次分析で傾向が出た(高い)項目にターゲットを絞ります

次はこの一次ターゲットに「再現性があるか」

ここに進みます

再現性が証明出来れば

この内容を徹底的に叩く事が「次の目的」になります。

「次の目的」が絞り込んだ項目の更に深いデータ取得です。

この繰り返しが「データ分析の肝」になり

これが俗に言う「PDCAサイクル」になります

最初から難しく彫り込むのでは無く

徐々に一次分析、二次分析と繰り返し原因を究明しながら

対策を重ねていく事が「品質管理」と言う活動です。

この様な事を「社員研修」でお伝えしております。

※私自身は門前の小僧ですがww